开宗明义,我的几个观点:

- 显然LLM (Large Language Model,大语言模型)已经开始在很多行业落地使用,而且这个趋势在 LLM 能力不断提升和使用成本持续下降的加持下,更加势不可挡

- 单模态的 AI,会广泛应用,但即使能力再强也很难制造新的大场景

- 在没有空间感知的 AI 出来前,所谓的多模态,都约等于单模态

- 真正的AGI(Artificial General Intelligence,通用人工智能)时代,道长且阻

- 我觉得EAI(Embodied Artificial Intelligence,具身智能)很有意思,可以制造大场景出来

为啥聊这个问题?

昨晚共享单车下班的我,等红灯中,听觉系统全力接收着耳机里《我看见的世界》播放声的同时,过滤了绝大部分的街头嘈杂。思绪也紧跟着李飞飞踉跄起步地 ImageNet 起伏。突然,潜意识听觉系统在喧闹的街头捕获到这几个声音片段“在一个大模型公司….人工智能…”。

情不自禁的顺着声音寻去,哇,我能想到最幸福的一家人的镜头:一辆自行车、依偎在一起的一家三口。声音来自坐在后座的妈妈,这是一对中年夫妇,外表看不出职业,不过大概率不是 IT 圈子的人。

突然之间,有点理解为啥那么多人“鼓噪” AGI(Artificial General Intelligence) 元年要来/已来了。的确,从 22 年底的 OpenAI 横空出世,似乎大家就不怎么提ML、DL,而是直接AGI、至少也是 LLM 起步。

从用户的角度,基于这一波 AI 技术的能力和使用成本,我丝毫不怀疑 AI 在各个行业的应用较之前会有大幅度的提速,甚至会影响千百年来信息/知识在人类的流动/传播方式。

虽然通用大模型已经有了非常强大能力,特别是这几天,各路媒体都争相报道 OpenAI惊天地泣鬼神的o1,那架势简直就差吹口仙气就蹦出个大活人了。想着Cursor就能薅把羊毛,见识一下 o1-preview,结果告诉我:不交钱的,排队去。

OpenAI 的这波操作,虽然看到了些东西,但我更愿意相信其中很大成分是类似Sora的资本需要。因为基于现有的能力边界,各种 LLM再怎么折腾,也是孙悟空跳不出如来佛的手心:语言模型学到了生成一个字符串的概率,仅此而已!对,是字符串,都不是语言。

你问大模型,太阳是什么形状;大模型告诉你“圆的”。他知道对于“太阳是什么形状”这个问题,最好的回答是“圆的”,但是大模型对“圆形”的形状是没有任何感知的。不管诸如 Chain of Thought,Emergence,RLHF,RL,CoT,Scaling Laws 等一众不明觉厉的概念能给人带来多少多巴胺,兴奋之后,总是逃不过这个现实!

知道一个事物不能做什么,是用好它的前提!

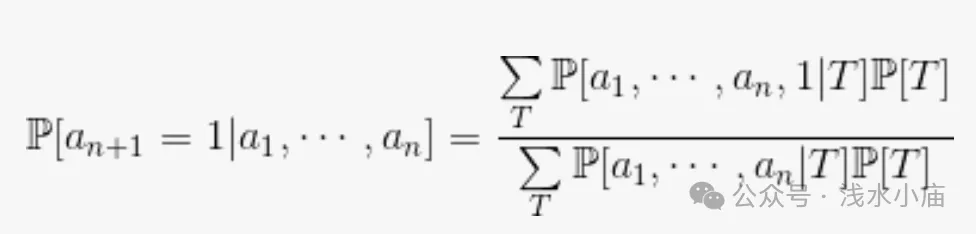

当下 LLM 的能力边界 – 所罗门诺夫归纳法

ChatGPT 横空出世之初,行业内对这样的能力提升解释为涌现(Emergence)。本人还有幸现场听过我们的一个院士也言辞凿凿地聊这个大模型的“未解之谜”。直到去年八月份,曾经的 OpenAI 首席科学家Ilya Sutskever在一次公开演讲中说 ChatGPT 的理论基础是所罗门诺夫归纳法。之后,特别是国内一众大模型的能力都有一波大幅提升,不知道跟这个是否有关。但我确实觉得“Emergence”,很可能是作为烟雾弹而诞生的。

上面这个公式就是所罗门诺夫归纳法。他表明智慧归结为单纯的计算,而学习最重要的是信息压缩。

所罗门诺夫完备性

所罗门诺夫归纳法的完备性表明,如果数据中存在某种可计算的模式,那么最终会发现这一模式,所需时间与模式的所罗门诺夫复杂度成正比。

更准确地说,数据越复杂,所罗门诺夫认为得知其中隐藏的结构所需的信息量就越大。但所罗门诺夫完备性证明了必需的信息量绝不会超过数据的精致度(sophistication)

所罗门诺夫归纳法的不可计算性

不存在任何图灵机可以严格地执行这种计算。

根据先验概率的构造,过于复杂的理论对应的概率无论如何都会呈指数递减,因此可以被忽略。如果我们忽略这些理论的话,因为我们知道它们对所罗门诺夫归纳法的预测结果影响有限,那么不就可以做出所罗门诺夫归纳法的一个非常好的近似了吗?不幸的是,这也不行。

所罗门诺夫不完备性

这个定理断言,所有这样的算法都必然是不完备的。更准确地说,所有可计算的知识哲学都不可能检测出数据中的所有规律。

换个说法,无论你的知识哲学是什么,只要它是可计算的,那就存在某些可能存在的世界会让你上当受骗,你会在其中一直做出非常错误的预测!可计算性和完备性是两种不兼容的性质。

George E. P. Box有个名言“All models are wrong, but some are useful!”

可以说,这从第一性原理上解释了为什么当下的 LLM 本质是:模式化了的生成一个字符串的概率而已。但同时也必须承认现在大模型对字符串的“排列组合”能力,可能超越了大部分人类。

o1 改变了什么吗?

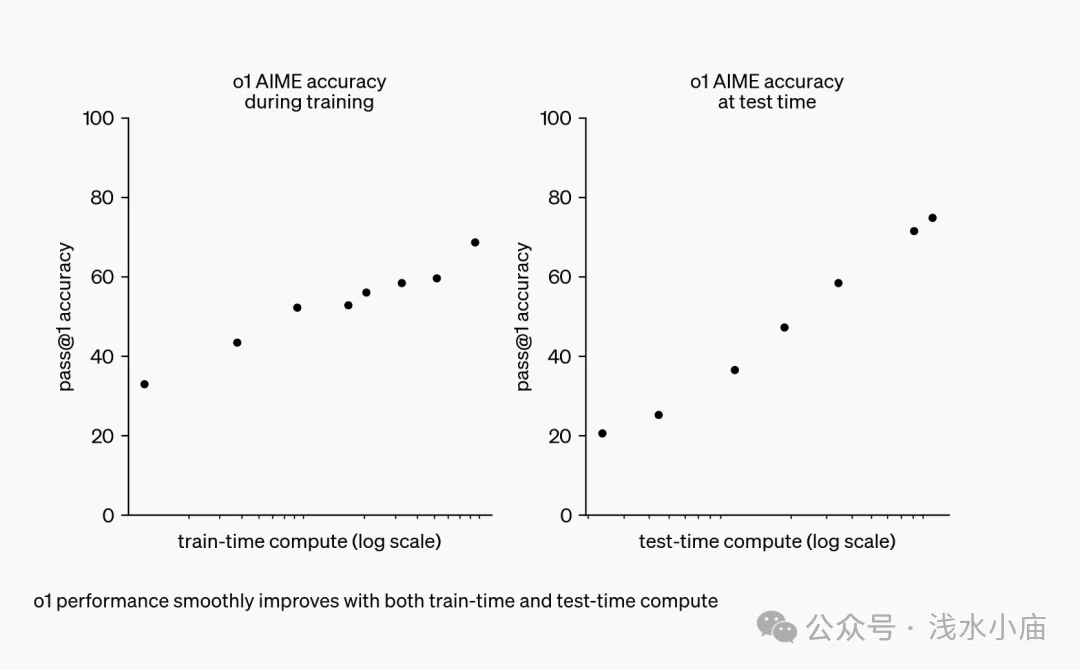

包括奥特曼自己在内的“大家”都在说,o1 又开启了AI 的一个新范式。虽然我不是科学家,但是真的不敢苟同。从系统输出角度,确实看到了(很多人体验后说的,我自己还没体验)模型的逻辑推理能力的提升。但其使用的方法都不是什么新的方法,而且也都有其他公司的成功案例(DeepMind的 AlphaGeometry),只是没有在 LLM 上实现:强化学习 RL(Reinforcement Learning)、思维链 CoT(Chain of Thought)、Test-Time Compute/Inference-Time compute。

Test-Time Compute/Inference-Time compute,也许是我不能理解,这不就是典型的工程方式提升模型回答质量的典型方法吗?如果 RL+CoT+ InferenceTimeCompute 就搞出了 reasoning,那我这个高级灵长类动物,只能拍拍脑袋,跟老祖宗说赶紧给我的智商加紧进化吧!(统计学上的推理:inference,逻辑意义上的推理:reasoning)

事出反常必有妖

“事出反常必有妖”是我非常推崇人事判定法器之一,屡试不爽。谈恋爱的时候,任何一方对另一方超乎寻常的“好”,肯定都另有图谋,一个人真心的喜欢另一个人,最真实的表现是远离他/她;老板哪天对一个员工格外客气、重视,肯定有正常工作以外的原因/目的,老板视员工如工具,这是利益角色决定的,无关人品;员工哪天工作异常的起劲,他一定是想搞点既定工作以外的事情。凡此种种,不胜枚举!当然,“妖”也有好有坏!

“人和妖精都是妈生的,不同的是,人是人他妈生的,妖是妖他妈生的……所以说做妖就像做人一样,要有仁慈的心。有了仁慈的心,就不再是妖了,是人妖。”

当下人工智能行业里,都有哪些“妖”?首先要考虑一下人们探寻“智能”的目的是什么。符合正常规律的目标应该是:提高对自然界基于给定输入的对应输出的预测能力,进而提升自身的生存状态。凡是违反这个目的的行为,基本上都可以判定是“妖”。目测大模型这里没有“人妖”,我是不是太腹黑了呀,哈哈哈。

- AI 很危险,需要监管

一个仅基于训练数据的 next-token 的预测模型,加上高准确率、通用场景。危险从何谈起?为啥那么多“大佬”不停鼓吹 AGI了,AI 牛到很危险的程度了,要政府监管?看一看都是哪些人就好了,凡事鼓吹这个的,都是既得利益者。政府监管越严格,准入门槛越高,后来的竞争就越少,自己的垄断地位就越高!

- 政府的算法备案、大模型备案

目前神经网络模型的不可解释性,稍有常识的人都知道。那么,政府监管备案,不用想也知道就是备了个寂寞!最近,一些备了案的大模型,出现政治不正确的回答,这是很正常的大模型行为。模型算法天天都在变化,你说备案、你要监管,除了寂寞和扼杀后来者,确实没剩下啥!

- o1-preview

从 Sora 跳票,到o1只有 preview。像马斯克问杨立坤:你这五年研究了个啥?我确实想知道 OpenAI 这一年来都在忙活啥,还在 preview。但 这都没有影响一个结论:训练和推理阶段,需要更大的算力了。英伟达 AI 科学家 Jim Fan 说这是 2022 年以来,大语言模型研究领域最重要的一张图:

我只能哈哈哈了。很不负责的说,o1 可能是主要靠工程手段提升的所谓的推理能力,那对算力的需求一定是咔咔咔翻倍呀。耳边似乎听到大股东说:下个月必须增长,否则…。以上都是是主观臆想的,权当娱乐,连英特尔和高通是亲哥两,我都是刚知道的。

- 今年以来,大模型投资者热情似乎降温了,但大模型真实的使用较去年增长了很多

据说从投资方对大模型的热情是降温了,因为没有看到规模性应用。因为没有规模性应用,所以就不会有规模性收益。对于那些急功近利的投资人来说,确实可以降降温了。

但是作为大模型的使用者,不管是从个人使用、本人公司业务的使用还是身边朋友的情况,大模型的使用在今年,真实的大幅度增加。投资人看不到,因为目前阶段的大模型落地一定是落在原有的业务流里面,表现出来的是老业务服务质量提升或者服务成本下降。本人听到的日 token 上亿的使用者,都不止一个了。

AI 未来之路

Deepmind 和 OpenAI 都定义了 AGI 的发展路径,感觉还是 OpenAI 的好理解一些:

- L1 相当于聊天机器人,像 ChatGPT 等,之前大家做了很多对话

- L2 叫推理者,可以做复杂问题深度思考的推理。

- L3 叫智能体,「数字世界」走向「物理世界」,要去改变,去交互。

- L4 是创新者,要去发现、创造一些新的东西,或者发现一些新的知识。

- L5 是组织者,它可以去协同,或者有某种组织方式更高效地运转,

清晰记得曾经的一个梦中场景:几个朋友坐在我家客厅,起风了,有人起身想去关窗户,我叫他不必动,给大家展示我的最新科研成果,打开笔记本电脑,敲击几下键盘,通过 AI “魔法”,把窗户关上了。不知道这个梦是不是暗示,我将打开 AGI 的 L3 大门,嘿嘿!

虽然大模型已经开始了在很多行业的广泛应用,但是显然AGI 之路,可以说是路长且阻。不过我相信,在具身智能充分发展后,AGI 会引领一些新的大场景出来,他是提升了人的所达范围(身体的、思维的)、制造了新的场景,而不是目前我们看到的大多是暴力替代人工。

转自公众号「